Une révélation troublante a été faite par l'Université de Stanford concernant Laion-5B, une base de données d'images utilisée pour entraîner des intelligences artificielles génératives, y compris l'outil Stable Diffusion. D'après l'étude, parue le 20 décembre, cette base contenait plus d'un millier d'images pédopornographiques.

Une récente étude a montré qu'entraîner des modèles IA à partir d’images elles mêmes créées artificiellement produirait des résultats catastrophiques. Une nouvelle rassurante pour les photographes qui ont peur de voir l’IA devenir auto-suffisante et les remplacer.

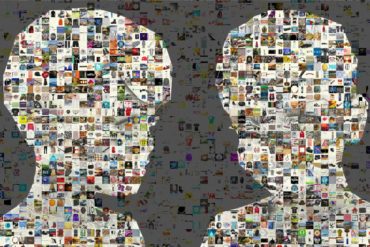

Depuis quelques mois, elles semblent envahir Internet – et brouillent notre perception de la réalité. Elles, ce sont les images générées par des IA. De Dall-E à Stable Diffusion, de Midjourney à Imagen, leurs "prouesses" n'en finissent pas de faire réagir. Phototrend revient sur ce phénomène de grande ampleur à travers 3 exemples concrets : la Une du dernier numéro du magazine Réponses Photo, un visuel autour du récent séisme en Turquie, et la "photo" gagnante d'un concours australien.

Mathieu Stern a partagé sur ses réseaux sociaux des images d’anciens appareils photo chinois qui ont semé la confusion. Créés grâce à l’intelligence artificielle, ces appareils n’ont jamais existé mais semblent plus vrais que nature. Avec cette série étonnante, Mathieu Stern expérimente à nouveau l’IA pour jouer de nos perceptions en proposant des images très réalistes d’objets pourtant fictifs.

La création d'images photoréalistes ex nihilo par l'intelligence artificielle avance à grands pas. Et ce n'est pas Aurel Manea qui vous dira le contraire. En utilisant une nouvelle solution nommée Stable Diffusion – concurrente de Dall- E 2 – le photographe bulgare a généré pas moins de 1200 "photos de paysage" plus vraies que nature. Un point qui pose de sérieuses questions éthiques…