Pensez-vous être capable de distinguer une « vraie » photo d’une image générée par une IA ? Si oui, vous surestimez peut-être vos capacités ! Car selon les résultats d’une enquête menée par des chercheurs du laboratoire Microsoft AI for Good, les capacités des humains en la matière sont… plutôt limitées.

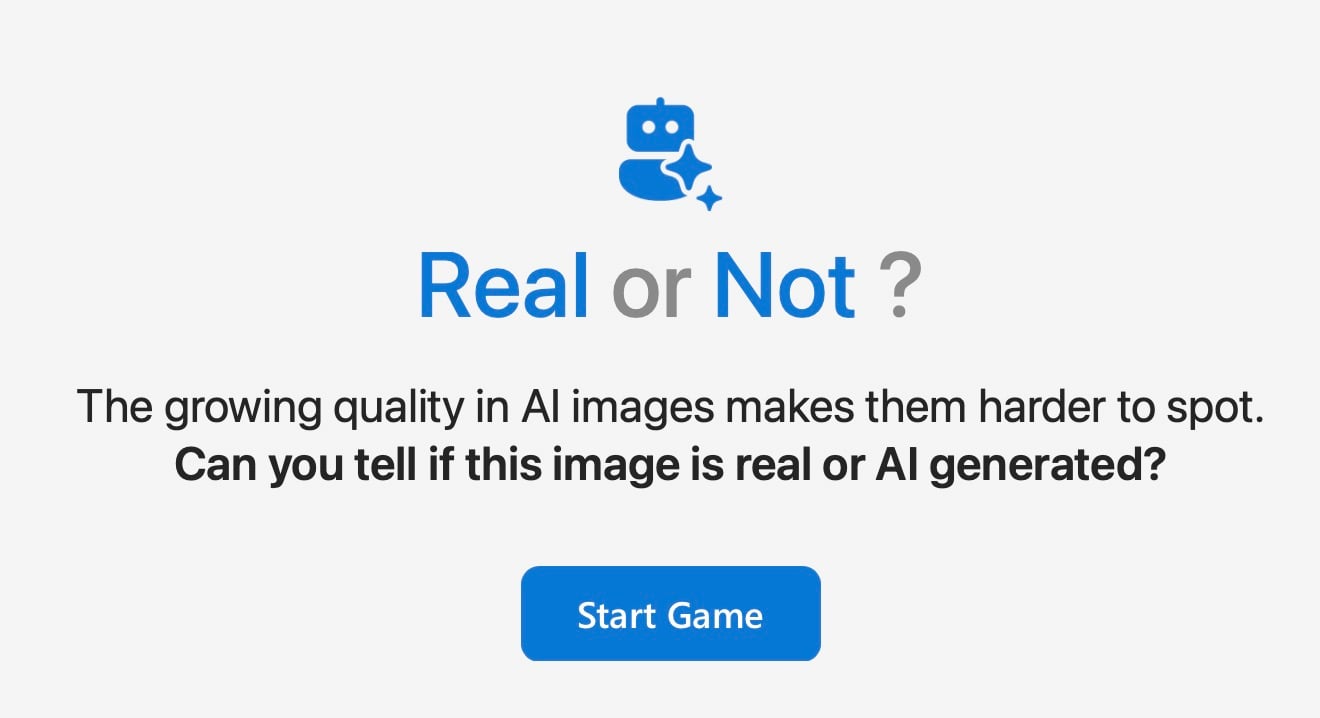

« Real or Not » : un test simple pour évaluer votre capacité à reconnaître les images créées par IA

Midjourney, Stable Diffusion, Dalle-E et ChatGPT… avec les progrès des IA génératives, il devient de plus en plus complexe de faire la différence entre des images réelles et celles créées de toute pièce. Partant de ce constant, huit chercheurs du laboratoire Microsoft AI for Good ont conçu un jeu en ligne appelé « Real or Not ».

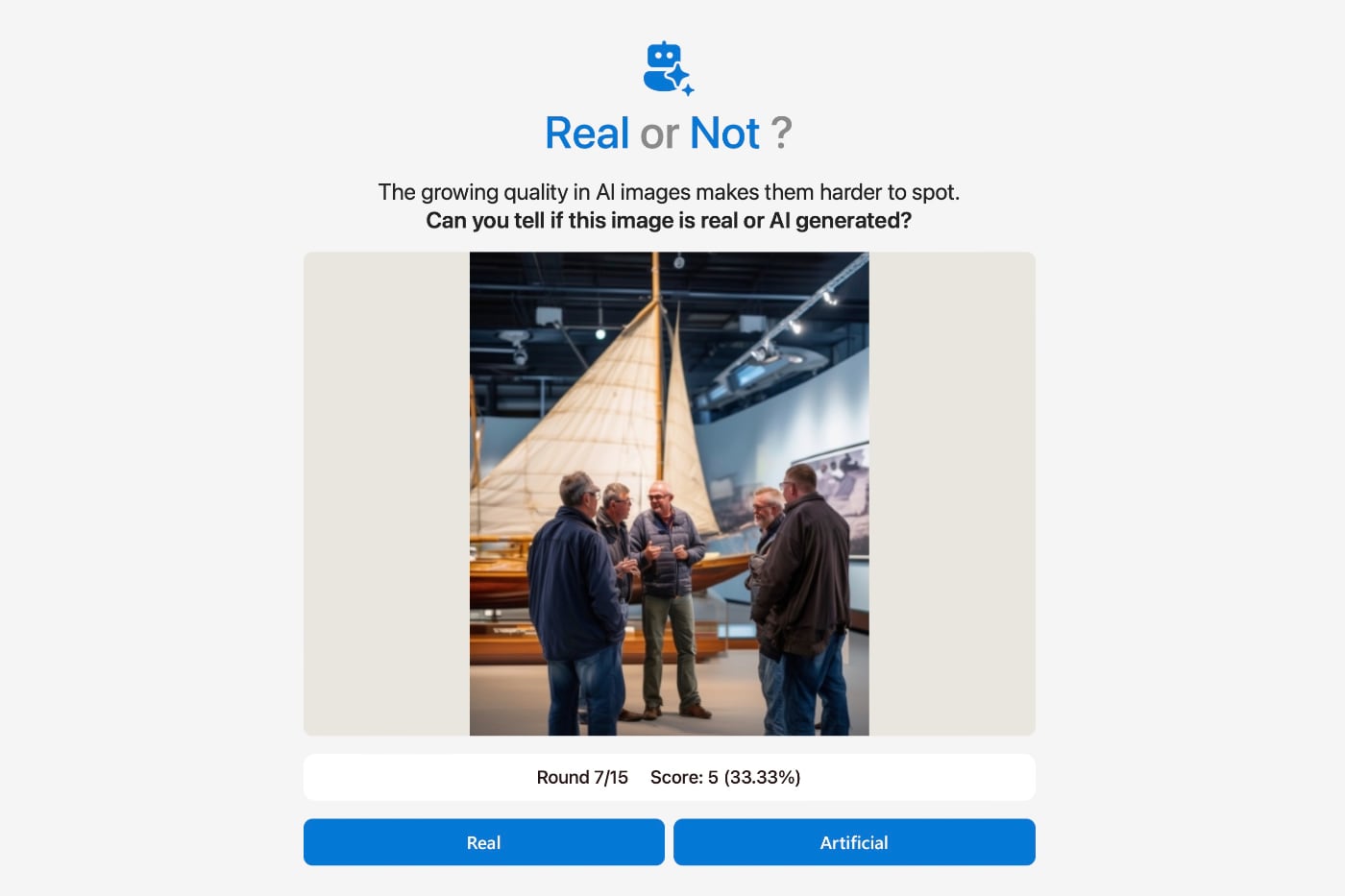

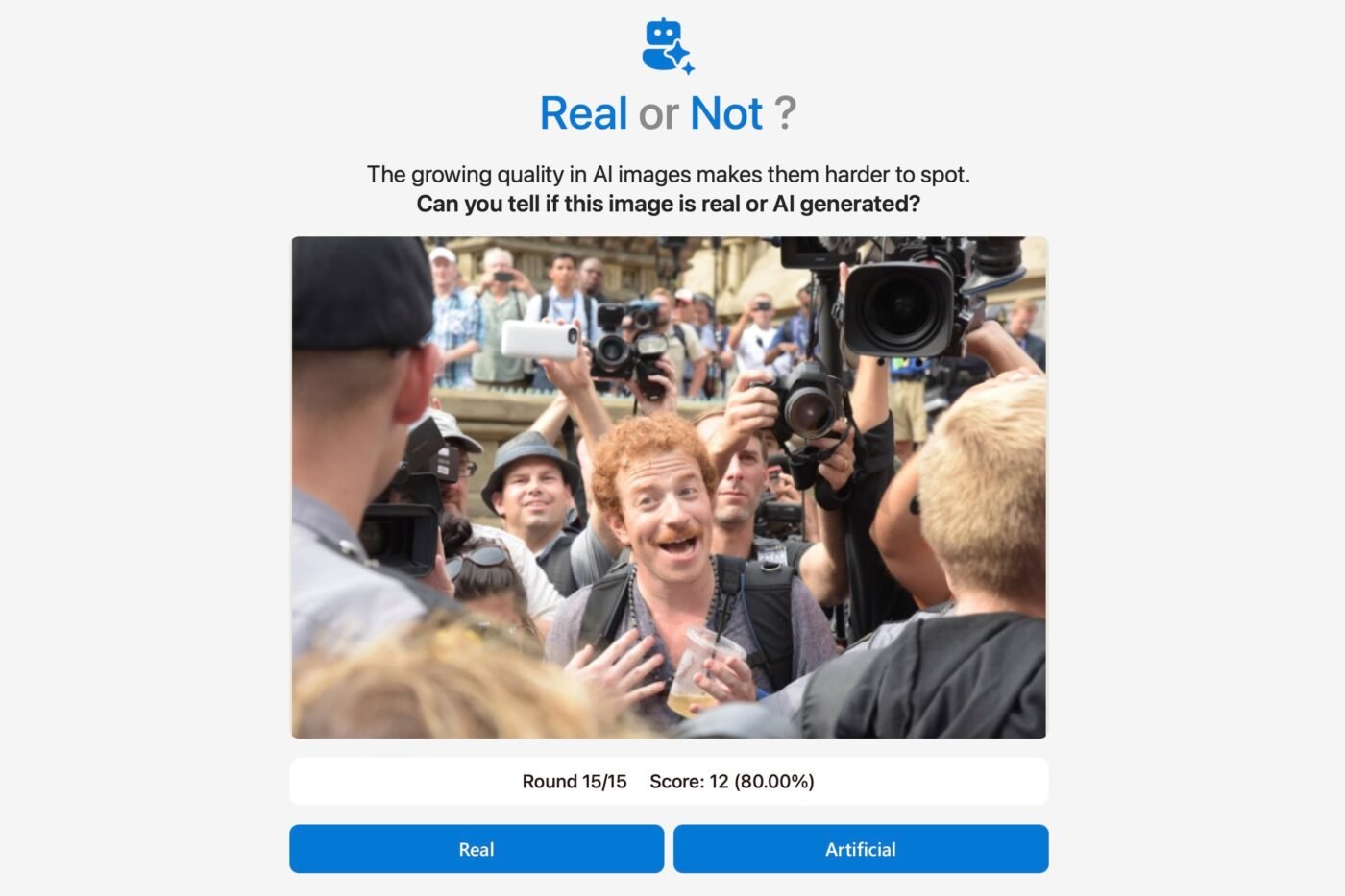

Le principe est simple : les participants visionnent 15 images aléatoires, et doivent déterminer celles qui sont de vraies photos et celles qui sont des créations d’une IA générative. Au total, L’analyse a porté sur environ 287 000 évaluations d’images par plus de 12 500 participants à travers le monde.

Problème : le taux de réussite global pour distinguer les images réelles des images générées par l’IA était de seulement… 62%. Soit à peine plus que celui d’un « simple » jeu de hasard. Dans le détail, les participants parvenaient davantage à reconnaître les « faux » portraits humains, mais avaient bien plus de mal avec les paysages naturels et urbains.

En outre, il semble que les participants ont beaucoup de mal à reconnaître les « vraies » photos dont une partie seulement a été modifiée. De même, les éclairages complexes ont tendance à duper davantage les participants – y compris avec des photos authentiques.

Pire encore, les « fausses » photos les moins bien détectées sont celles qui paraissent réalistes… avec un rendu amateur.

Les IA de détection bien plus efficaces que les humains !

Parmi les méthodes les plus à mêmes de duper les participants à cette étude : les GAN (Generative Adversarial Networks). Certes, ce procédé n’est pas récent (leur apparition remonte à 2014, une éternité dans le petit monde de l’IA) et il peine souvent à aller au-delà des images fournies dans le dataset qui a servi à leur entraînement.

Mais d’après les auteurs de l’étude, leur capacité à créer des portraits réalistes reste inégalée, avec un taux de reconnaissance par l’humain qui peine à dépasser les 50 % !

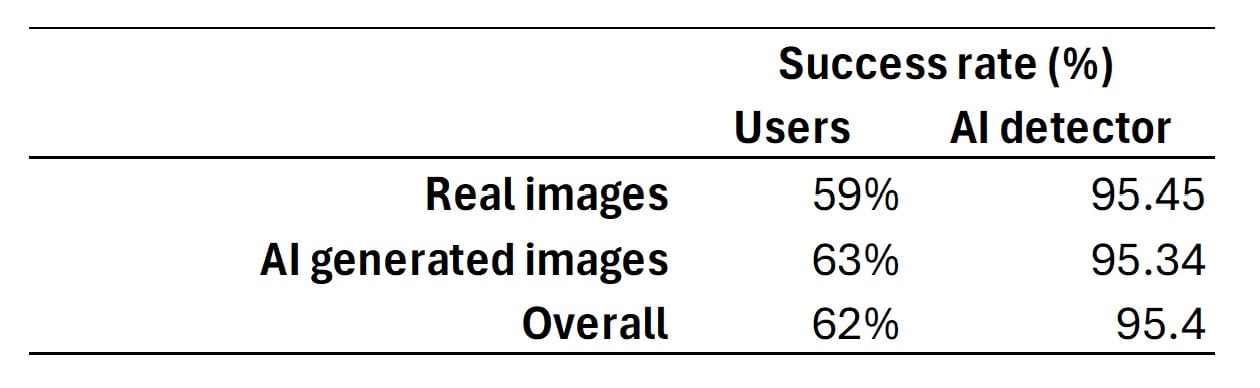

Pendant ce temps, les IA de détection des « vraies-fausses images » affichent des scores bien plus élevés. Là où les humains se trompent dans 1/3 des cas, les machines réussissent à reconnaître 95,4 % des visuels générés par IA.

Les deepfakes, un enjeu bien réel

Le timing de cette étude ne doit rien au hasard. En effet, les outils de génération d’images par IA sont de plus en plus répandus – et sont parfois implantés au sein même du système d’exploitation de nos smartphones et ordinateurs. De même, les systèmes de génération de vidéos (Veo 3 de Google, par exemple) sont de plus en plus adoptés – et leurs résultats bien plus crédibles qu’auparavant.

Si de vraies-fausses images amusantes ou divertissantes sont plutôt anodines, les conséquences des deepfakes sont bien plus sérieuses : doutes constants sur l’authenticité des informations en ligne, propagation de fausses informations, manipulation des opinions publiques et, à terme, menaces pour les processus démocratiques.

Ainsi, les auteurs de cette étude plaident pour plus de transparence. D’une part, au travers des Content Credentials (filigranes invisibles appliqués aux visuels générés par IA). Mais aussi grâce à des outils de détection plus efficaces basés sur l’intelligence artificielle.

Dans tous les cas, les images générées par IA remplissent peu à peu l’Internet – Pinterest en est un très bon exemple. Et il est plus que temps d’éduquer notre œil (et notre esprit critique) à trier le bon grain de l’ivraie.

L’étude complète, intitulée How good are humans at detecting AI-generated images? Learnings from an experiment, est disponible sur cette page.