Sur le web, certains médias viennent d’annoncer qu’OpenAI allait intégrer un système de filigranes automatiques pour ses visuels créés via la version gratuite de ChatGPT, dans le but d’en authentifier la provenance et de renforcer la transparence. Toutefois, en tant que membre de la C2PA, OpenAI intègre déjà des métadonnées pour marquer ses visuels créés par IA, et ce depuis début 2024.

OpenAI intègre la norme C2PA pour la provenance des images

Face à l’essor des images générées par intelligence artificielle et aux risques de désinformation, OpenAI travaille depuis plusieurs mois déjà à tracer l’origine de ces contenus via des filigranes numériques.

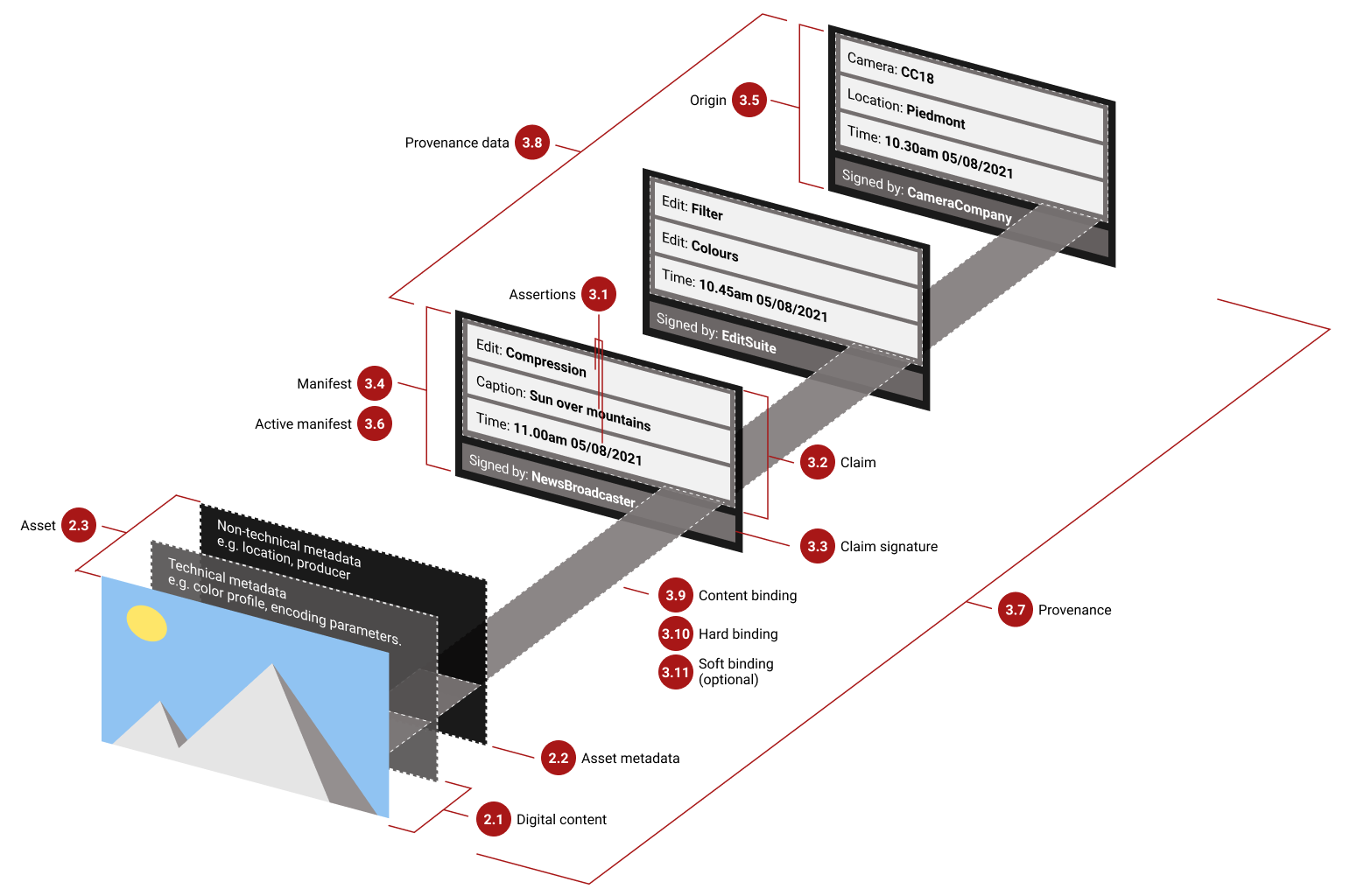

Son générateur d’images DALL-E 3 intègre ainsi depuis février 2024 des métadonnées conformes à la norme ouverte C2PA (Coalition for Content Provenance and Authenticity). Ce standard, soutenu par des acteurs comme Adobe et Microsoft, mais aussi Sony, Nikon, Leica ou Canon, vise à certifier l’authenticité – et la provenance – d’une image en embarquant dans le fichier une signature infalsifiable sur son origine, et les modifications effectuées.

OpenAI a déjà rejoint le comité directeur de la C2PA afin de contribuer à son développement aux côtés d’autres entreprises du secteur.

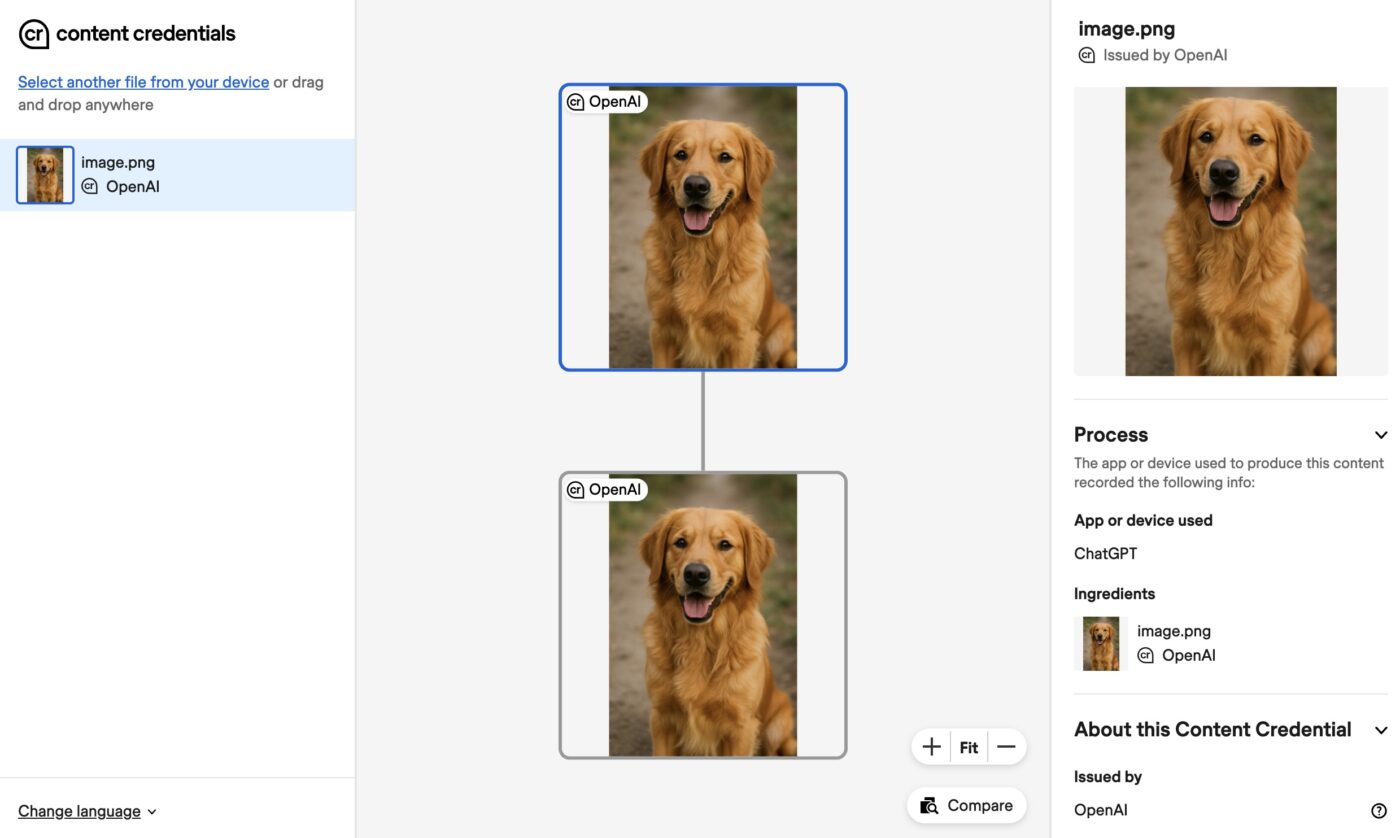

Depuis début 2024, toutes les images générées (ou éditées) via DALL-E dans ChatGPT ou via l’API d’OpenAI embarquent automatiquement un tag C2PA. L’objectif affiché est de permettre à n’importe quel outil compatible (tel le site Content Credentials Verify) de vérifier qu’une image provient bien d’un modèle d’IA d’OpenAI.

Des balises invisibles pleines de promesses…

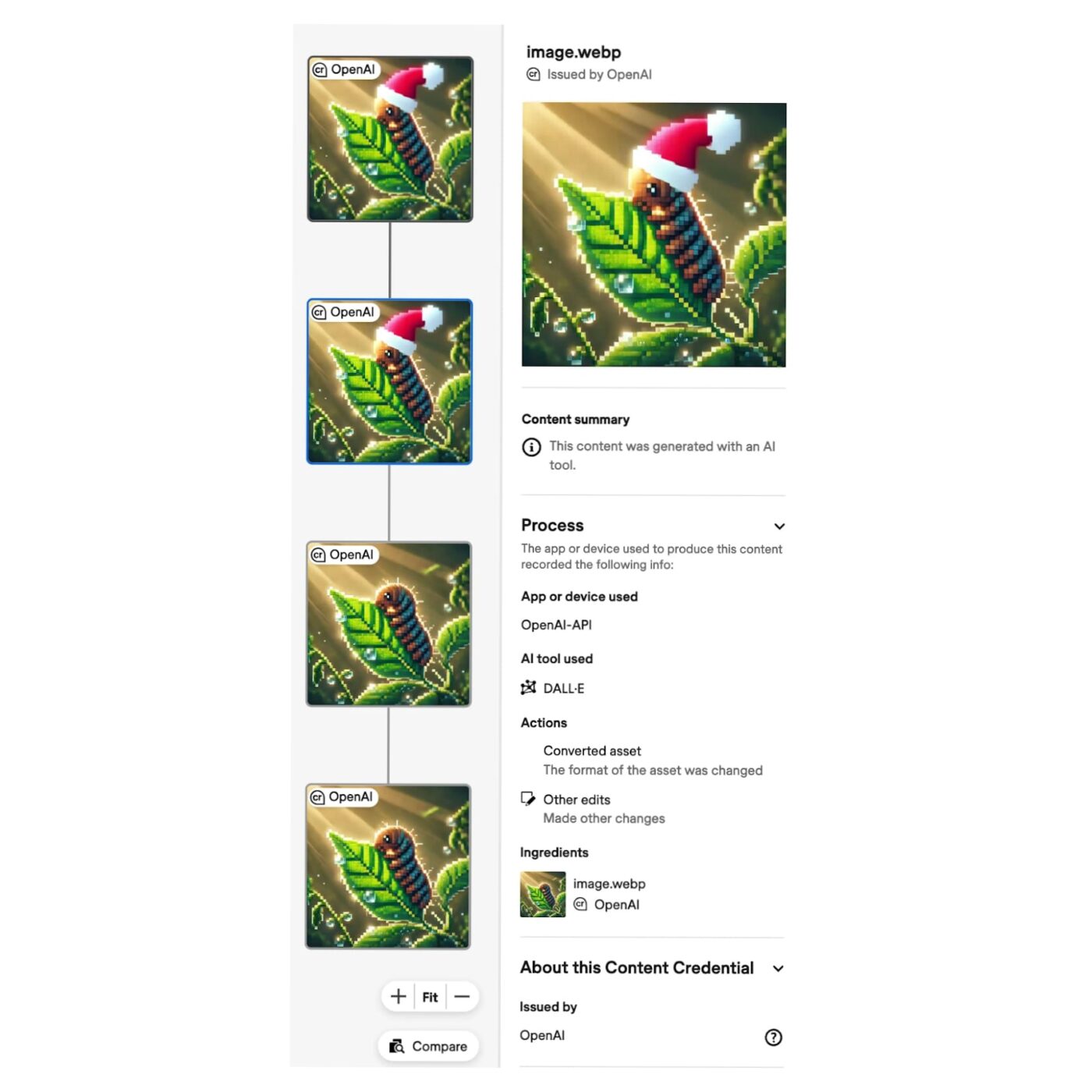

Un exemple fourni par OpenAI montre l’ajout d’un bonnet de Noël sur une image de chenille : la norme C2PA consigne dans les métadonnées la création initiale via DALL-E puis l’édition apportée, avec le détail de ces modifications visible dans les “content credentials”.

La balise C2PA embarque ainsi le nom de l’outil (ici DALL-E) et la liste des opérations effectuées, le tout étant signé cryptographiquement pour garantir l’intégrité de ces informations. OpenAI assure par ailleurs que l’ajout de ces balises est transparent pour l’utilisateur, avec un impact négligeable sur le temps de génération et aucune dégradation de qualité d’image, au prix d’une légère augmentation de la taille des fichiers (de 3 à 32 % selon les cas).

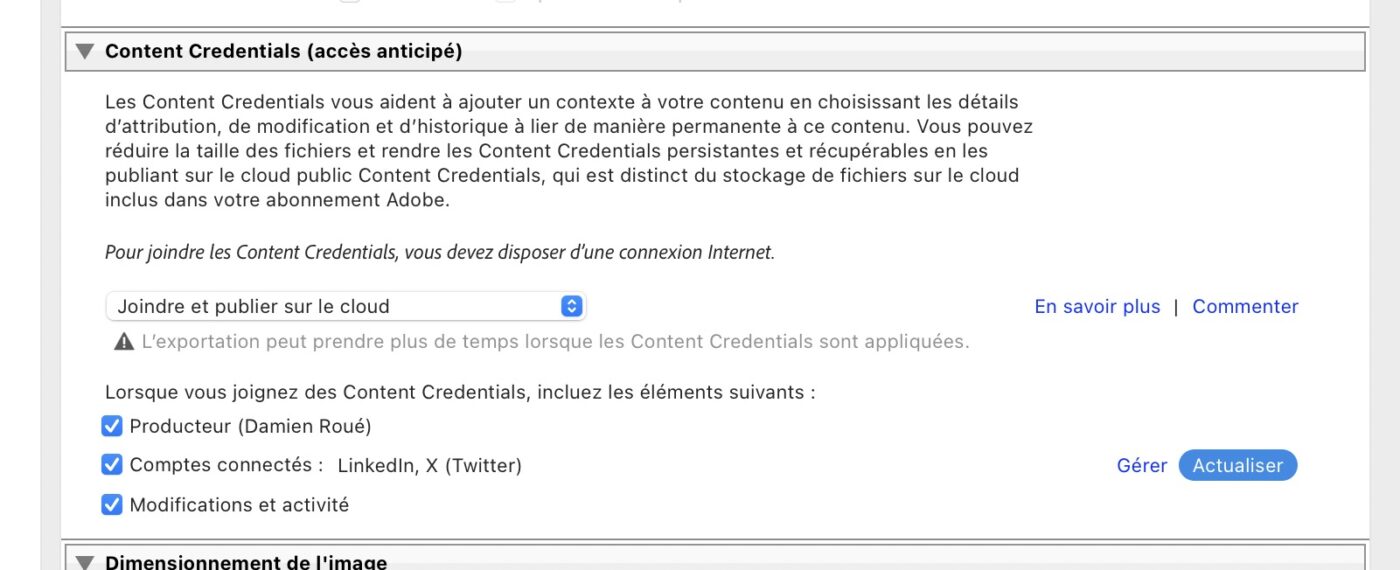

D’autres acteurs comme Adobe ont intégré cette fonctionnalité dans leur flux de travail. Dans Lightroom et Photoshop, la fonction Content Credentials permet d’embarquer des informations sur l’origine, les modifications et l’auteur d’une photo directement dans le fichier exporté, principalement au format JPEG pour l’instant. Cela agit comme un passeport numérique.

…Mais avec des limites

Cette solution de filigrane invisible présente toutefois des limites. OpenAI reconnaît que ces métadonnées d’authenticité “ne sont pas une solution miracle” et “peuvent être aisément retirées, volontairement ou par accident”. En pratique, la plupart des plateformes en ligne effacent les métadonnées des images lors de la publication, et une simple capture d’écran suffit à éliminer tout tag d’origine.

« L’implémentation C2PA doit couvrir tout le processus photographique, de la capture à la post-production. » comme nous l’expliquait un responsable de Nikon, mettant le doigt sur la nécessité d’une chaîne de validation complète, de la capture de l’image jusqu’à sa diffusion sur les réseaux sociaux, notamment.

En d’autres termes, l’absence de balise C2PA ne prouve pas qu’une image est « authentique », seulement que son historique a pu être perdu. Par ailleurs, ce mécanisme ne concerne pour l’instant que les images fixes : OpenAI a commencé par déployer ces filigranes dans le cadre de ses tests en 2023, et l’intégration aux contenus vidéo générés (via le modèle Sora) demeure à l’état de projet à ce jour.

OpenAI souligne ainsi travailler en parallèle sur d’autres approches techniques, notamment des filigranes algorithmiques invisibles et résistants directement dans les médias, ainsi que des outils capables de détecter a posteriori un contenu généré par IA. L’enjeu sera de combiner standards ouverts (C2PA) et innovations privées pour restaurer la confiance face aux manipulations numériques à l’ère de l’IA.